Vraag: is SEO log file analyse ook relevant voor AI Search ?

Antwoord: Absoluut. Ja, SEO log file analyse is zéér relevant voor AI search en wordt zelfs belangrijker dan het al was voor traditionele SEO. Het biedt het enige directe bewijs van hoe AI-systemen uw website crawlen en welke content ze gebruiken om hun antwoorden (zoals Google’s AI Overviews) te genereren.

Inhoud:

- Wat is Log file analyse precies?

- Waarom Log File analyse voor SEO én GEO belangrijk is?

- Output nader bekeken

- Adviezen om het crawl budget te verbeteren

- Tools om crawling en indexering te sturen

- Basis voor Generative Engine Optimization

- Besluit

Wat is Log file analyse precies ?

Log file analyse voor SEO is het proces waarbij je aan de hand van de server-logbestanden van je website nagaat welke webpagina’s precies opgepikt worden door search engines en AI-agents.

Elke keer dat een bot of bezoeker een pagina oproept, wordt dit in een logbestand geregistreerd. Door die data te analyseren, ontdek je:

- welke pagina’s vaak worden bezocht door crawlers (zoals Googlebot of GPTBot)

- of waardevolle content wel wordt gecrawld

- waar crawlbudget verloren gaat aan irrelevante of technische pagina’s

Deze analyse is met name ook relevant voor AI-zoekmachines omdat zij het crawl- en indexgedrag kunnen spiegelen aan generatieve output.

Aan de hand van de log file(s) van je website, die elke webmaster je kan bezorgen of die je zelf kan downloaden van de server, en met behulp van een Analysis tool ( zoals bijvoorbeeld Screaming Frog ) kan je nagaan of je website wel correct functioneert qua SEO. Logs bevatten ongelofelijke accurate data die je toelaten veel beter te begrijpen hoe zoekmachines je website interpreteren.

Waarom Log File analyse voor SEO én GEO belangrijk is ?

- Log file analyse is dé manier om na te gaan of een website een goede crawl-efficiëntie kent; immers, wanneer een site qua zoekmachine optimalisatie niet optimaal werkt, komt dit tot uiting in de crawling.

- En een suboptimale crawling heeft een direct negatieve impact op je zoek rankings.

- Dit is eigenlijk de reden waarom technische SEO zo belangrijk is: vooraleer je site kan ranken op de juiste zoekwoorden, moeten zoekmachines je site eerst correct kunnen crawlen;

- Controleert precies welke URLs wel en welke niet gecrawld kunnen worden door de search bots;

- Verifieert of ‘low-value-URLs’ worden gecrawld en geïndexeerd;

- Checkt de response codes die zoekmachines tegenkomen tijdens het crawlen;

- Identificeert crawl manco’s;

- Detecteert aan welke pagina’s de zoekmachine voorrang geven & als de belangrijkste beschouwen;

- Informeert je over een hele reeks vaak onbekende technische SEO problemen die je anders nooit had opgemerkt;

- Ontdekt ‘crawl budget waste’

- crawl budget’ : het aantal URLs die Google kan en wil crawlen. Deze hoeveelheid URLs wordt bepaald door de zogenaamde domain authority (DA)

- hoe hoger de DA, hoe hoger het crawl budget dat een zoekmachine wil toewijzen aan een website

- mits dit crawl budget niet onbeperkt is, moeten we dus voorkomen dat Google niet relevante pagina’s aan het crawlen is.

- Geeft inzicht in hoe AI-bots of generatieve zoekmachines je site interpreteren;

- Helpt bij het identificeren van content die wellicht bij AI als ‘low value’ wordt geclassificeerd.

Output nader bekeken

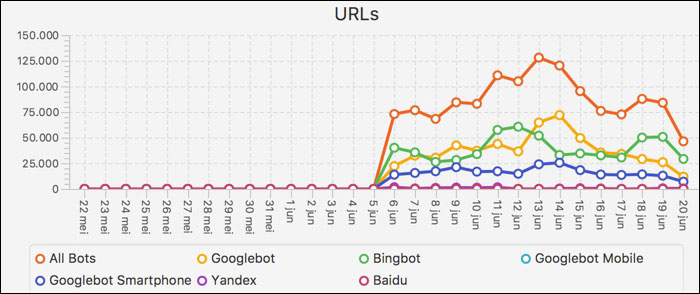

Crawled URLs identificeren

- Welke URLs werden door de Search Engines nu eigenlijk gecrawld voor een bepaalde periode ?

- Dit zijn dus webpagina’s waarvan zoekmachines weet dat ze bestaan

- Weet dat naast de Google-bot, er nog andere search bots bestaan:

- de bekendste hiervan is Bing-bot,

- maar je hebt bijvoorbeeld ook Baidu (China) en Yandex (Rusland)

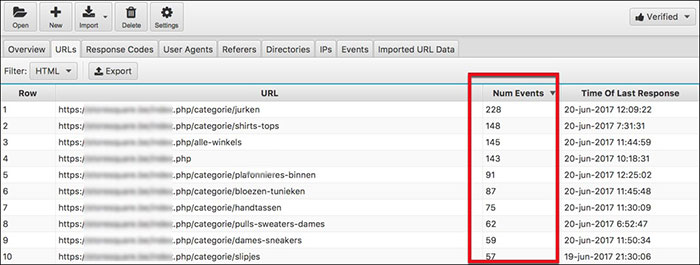

Low value URLs identificeren

- Je ontdekt welke URLs frequent worden gecrawld

- Hierbij ontdek je ongetwijfeld webpages die door de search-bots veel frequenter worden bezocht, maar die eigenlijk voor de site helemaal niet belangrijk zijn

- Hiermee kan je het crawl-budget efficiënter gaan inzetten

- Bijvoorbeeld: product-filter-pagina’s die weinig waarde toevoegen maar continu door bots bezocht worden = risico op ‘crawl budget waste’.

Minste / Meeste gecrawlde webpagina’s

- Hoe frequent een searchbot een pagina bezoekt hangt onder meer af van de zogenaamde google freshness

- Het gaat jammer genoeg niet vanzelf om je belangrijkste URLs vaker te laten crawlen;

- Daarom best handig om te ontdekken welke van je belangrijke pages frequent bezocht worden en welke juist niet, om alzo een eventueel onderliggend probleem te ontdekken;

- Omgekeerd geldt natuurlijk ook: je ontdekt of irrelevante URLs van lage kwaliteit worden gecrawld en geïndexeerd. Zeker voor grote websites wil je dit vermijden door dergelijke niet gebruiksvriendelijke pagina’s te blokkeren via bijvoorbeeld de robots.txt file.

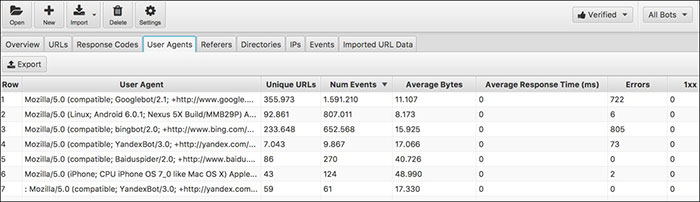

Bezoekfrequentie Bots

- Welke user-agents bezoeken de website het vaakst ?

- Voor de meeste Europese websites is Googlebot veel belangrijker dan bijvoorbeeld de Baiduspider.

- Met de huidige LLMs zijn er meer bots dan ooit

- Google-Extented (Gemini)

- ChatGPT-User

- PerplexityBot

- ClaudeBot

- ByteSpider (TikTok)

- AppleBot

- enz.

- Wordt dit niet bevestigd in je logdata, dan is dit interessant om verder te onderzoeken, bijvoorbeeld door het robots.txt bestand grondig onder de loep te nemen.

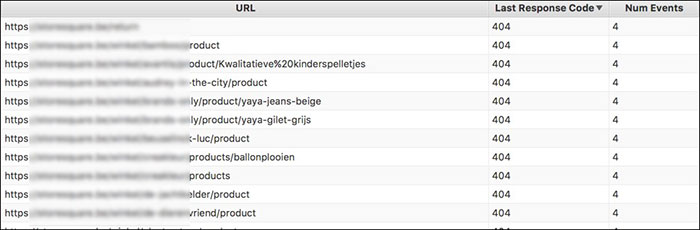

Crawlfouten

- Je kan op eenvoudige manier eveneens een inzicht krijgen welke webpagina’s niet konden bekeken worden door de bots

- Dit door te filter op ‘response-code=404’

- Zitten er hoog-converterende URL’s tussen, dan weet je wat te doen.

En zoveel meer

- Je kan met Log file analyse voor SEO nog veel meer insights bekomen; het zou ons te veer leiden om ze allemaal te spreken

- Weet dat je ook volgende data kan bekomen:

- crawlfrequentie per subdirectory en productgroep

- crawlhoeveel per dag / week / maand

- check van search bots IP-adressen

- ontdekken van URLs die ’te zwaar’ en/of te traag zijn

- welke spambots bezoeken je website

Adviezen om het crawl budget te verbeteren

Crawl Budget is belangrijker dan ooit. Immers, er zijn nu meer bots die je site willen crawlen (namelijk de traditionele bots én diverse AI-bots).

Kan het crawlbudget van een website verbeterd worden? Ja zeker, op de eerste plaats door de site-overkoepelde technische issues op te lossen. Hieronder 8 tips voor een hoger crawl budget :

- Verhoog je link autoriteit

- Zorg voor goed gestructureerde sitemaps

- Verbeter de laadsnelheid van de website

- Vermijd 404-links en 301 redirect paden

- Verwijder pagina’s met quasi dezelfde content

- Bouw een logische site architectuur op

- Gebruik Google Search console om crawl errors te ontdekken: hoe staat het met de fout-pagina’s, uitgesloten URLs, crawlafwijkingen, webpagina’s met omleiding, uitgesloten 404’s, alternatieve pagina’s, ect ?

- Verifieer op regelmatige basis via SEO logo file analyse welke pagina’s Google Bot bezoekt.

Tools om crawling en indexering te sturen

Als SEOer beschik je gelukkig over een aantal tools om de crawling en indexering van een website te sturen. Deze methodes hebben alleen een andere invloed op de crawlbaarheidheid, indexeerbaarheid en doorgave van de linkwaarde van een webpagina.

Een URL, met een canonical tag die niet self referencing is, wordt nog steeds gecrawld, is niet meer indexeerbaar, maar zal wel nog linkwaarde doorgeven aan de verwijzende URL. Pagina’s die in het robots.txt bestand zijn opgenomen als ‘disallow’, zullen niet meer gecrawld worden, bijgevolg zijn ze ook niet meer indexeerbaar en geven ze geen linkwaarde meer door. Webpagina’s die een robots directieve als noindex in de ‘head’ hebben, zijn wel nog crawlbaar, maar niet meer indexbaar en geven geen Google juice door. URLs met het Hreflang attribuut blijven crawlbaar, indexeerbaar, maar geven geen linkautoriteit door, waar bij paginatie dit laatste wel het geval is.

In onderstaande tabel een overzicht van de diverse controle methodes en hun invloed op het crawl- en index-proces.

| Tool | Crawlbaar ? | Indexeerbaar ? | Doorgave linkwaarde ? |

|---|---|---|---|

| Canonical tag | ja | nee | ja |

| Robots.txt | nee | nee | nee |

| Robots directives | ja | nee | nee |

| Hreflang | ja | ja | nee |

| Paginatie | ja | ja | ja |

De basis voor Generative Engine Optimization (GEO)

Log file analyse is een fundamenteel onderdeel van Generative Engine Optimization (GEO), de nieuwe discipline van optimalisatie voor AI-antwoorden.

Door te analyseren welke pagina’s AI-bots het vaakst en succesvol crawlen, leer je welke content zij als waardevol beschouwen. Je kan deze pagina’s vervolgens prioriteren en verder optimaliseren voor “extractability” (zodat een AI er makkelijk een direct antwoord uit kan halen) door:

- Duidelijke koppen (H1, H2) te gebruiken.

- Directe antwoorden te geven op specifieke vragen.

- Gestructureerde data (Schema.org) toe te passen.

Je weet welke pagina’s je moet optimaliseren omdat de logbestanden vertellen waar de AI-bots hun tijd doorbrengen.

| Meer weten over GEO ? Download onze gratis GEO Whitepaper. |

Besluit

SEO log file analyse is niet enkel een technische oefening, het is eveneens een strategisch AI-SEO-instrument. Het helpt je te begrijpen hoe zoekmachines én generatieve AI’s jouw site lezen, waarderen en gebruiken.

Wie nu al zijn logs interpreteert met AI-search in het achterhoofd, bouwt een duurzame voorsprong op in een toekomst waarin zoekresultaten niet langer enkel lijsten zijn, maar conversaties.

Blijf voor op je concurrentie. Schrijf je in voor onze maandelijkse nieuwsbrief

|

|